深層カルマンフィルタ (4)

…さて、ここからが本題。 同じ著者による新しい論文がアップロードされていたので、こちらも適宜参照しながら読み進めていく。

[1609.09869] Structured Inference Networks for Nonlinear State Space Models

問題設定

まずは基本となる状態空間モデルについて説明する。 今回対象とする状態空間モデルの生成モデルは次のように記述される。

はステップ

における観測値、外部入力、および潜在状態である。

はステップ

から

までの時間幅である。

状態遷移確率が直前の状態

の滞在時間(sojourn time) に依存するため、正確には上のモデルは準マルコフ過程 (semi-Markov process) と呼ばれる確率過程と解釈することもできる。

は多層パーセプトロンで近似された非線形関数である。

上の生成モデル のパラメータ

、および認識モデル

のパラメータ

を求めることが学習の主な目的となる。

ただし、

,

、

である。

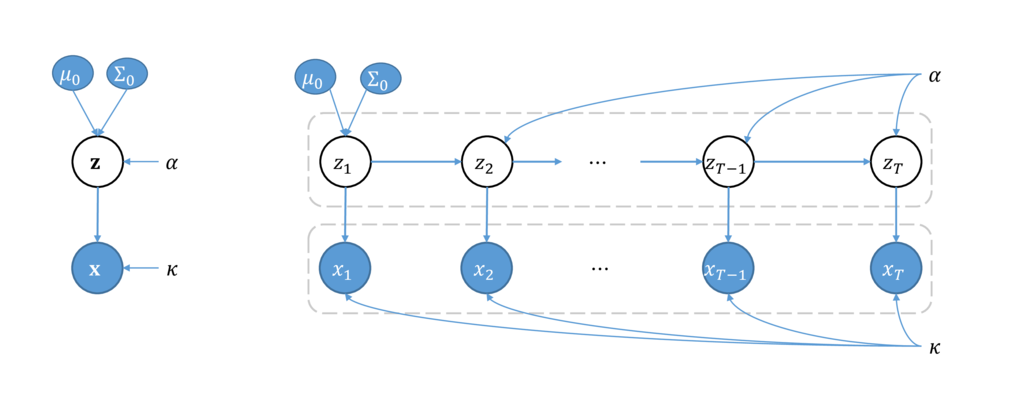

生成モデルのグラフィカルモデルは次のようになる(外部入力は省略)。

左側を時間方向に展開すると右図のような形になる。

構造としては変分自己符号化器に似ているが、状態遷移確率に関するパラメータも推定の対象になっていること、および状態遷移確率に非線形写像が含まれることから の事前分布が正規分布にならない点が異なる。

状態空間モデルの変分下限

さて、上記モデルに対し変分ベイズ学習を考える。 まず、マルコフ性より(真の)事後分布は次のように分解することができることに注意する(文献の Theorem 5.1)。

これに対応し、認識モデルを次のように分解する。 (上の定理の内容に従うのであれば)すべてのステップにおける外部入力・観測値の値は必要ない気がするけど。

これを用いて、変分下限の各項を整理する(導出はもとの文献などを参照)。 まず第一項について整理すると次のようになる。

(グラフ構造より)

(

以外について積分消去)

ただし、 である。この分布は、

であれば上で分解した認識モデル

と一致するが、そうでなければ違う分布となるため、混乱を避けるため別の分布として表記した。

次に第二項のKL情報量は次のようになる。

(被積分項ごとに分解)

(積分消去+整理)

(長い…) まとめると、状態空間モデルの変分下限は次のように書くことができる。

上式を について微分可能にするために

に課す制約を考えていくのが次の課題。

ここまでで特に深層学習らしい話が出てきていない気がする(強いて言えば SGVB ぐらい?)。 その辺りの話は多分次あたりに出てくる気がするが、今回はここまで…